Datoteka robots.txt nalazi se u izvornom folderu sajta i sadrži uputstva za popisivače sajta (crawlere). Osnovna uloga mu je da sugeriše popisivačima gde mogu ili ne mogu da idu, ali oni nisu u obavezi da ga poslušaju. Uprkos uvreženom mišljenju robots.txt ne treba da se koristi za uklanjanje određenog sadržaja iz veb pretrage. Za takve svrhe bolje je da koristite noindex tag.

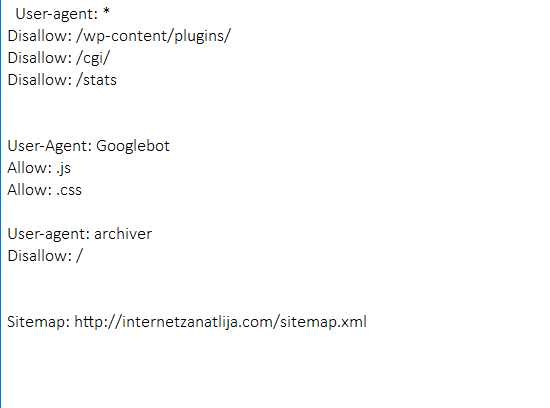

Osnovni elementi ovog tekstualnog fajla su;

User-agent – specificira određeni robot (može biti Guglov popisivač, Adsense itd..)

Disallow – zabrana pristupa

Allow – dozvola pristupa

Sitemap – daje adresu mape sajta.

Vidite na slici jedan primer.

U ovom slučaju od svih popisivača tražimo da ne pristupaju folderu plugins, cgi i stats, Googlebot popisivaču dajemo na znanje da treba da pregleda .js i .css fajlove, a popisivaču archiver u potpunosti zabranjujemo pristup. Tu je i adresa mape sajta.

U principu, ako ne razumete šta radite, najbolje je da ovu datoteku ne dirate. Google algoritmi su toliko pametni da već sami mogu da procene koji sadržaj je bitan, a koji ne.

Ako želite da menjate ovu datoteku, to u WordPressu možete uraditi direktnom izmenom datoteke na serveru ili pomoću plagina Yoast SEO.

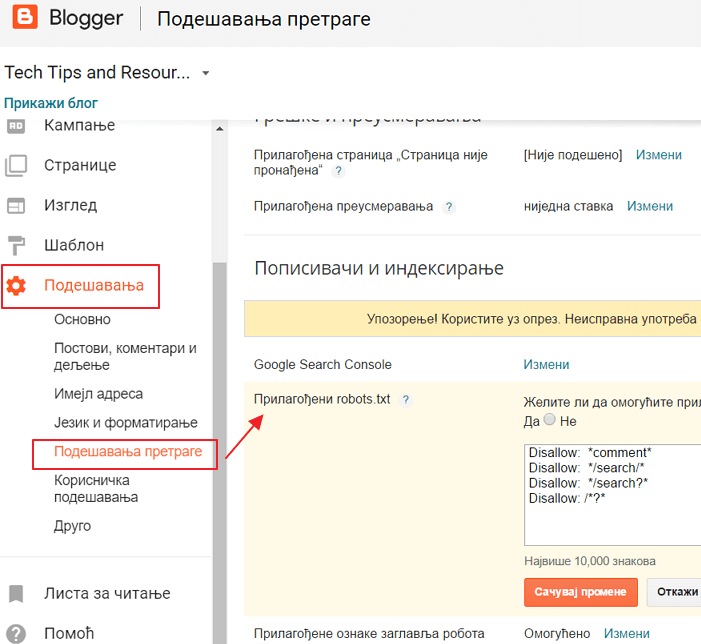

Kod Blogera samo treba da odete na Podešavanja bloga – pa podešavanja pretrage i tu potražite sekciju Popisivanje i mesto gde se menja robots.txt.

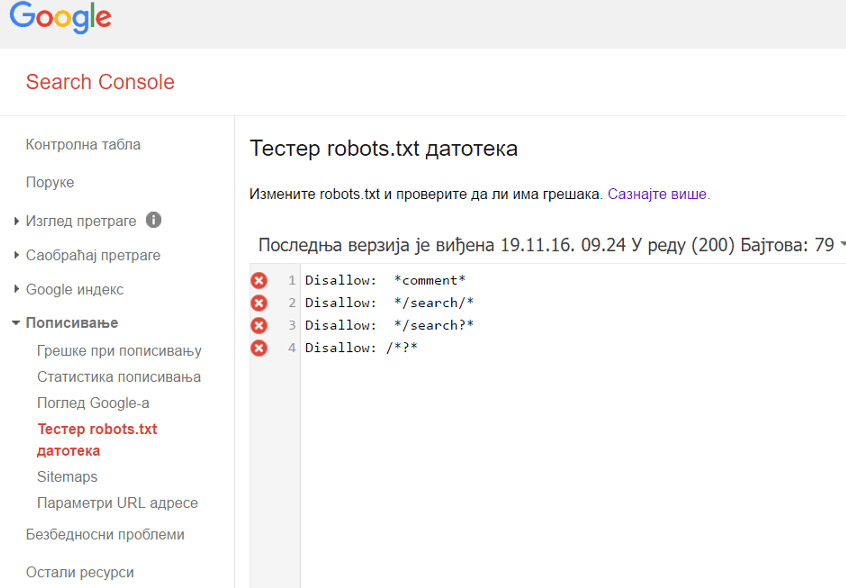

Pre nego što išta promenite istestirajte datoteku kako bi se uverili da je sve u redu.

To radite iz Search Console (bivše Alatke za vebmastere).

Odete u sekciju Popisivanje (Crawl) i tu potražite Tester robots.txt datoteka. Premda kao što smo već rekli, ako se ne razumete bolje je da ništa ne menjate.